重庆警方公布多起利用AI编造谣言的案件

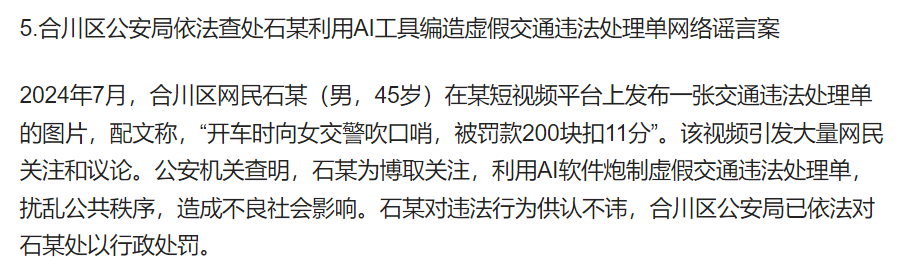

近日,重庆警方公布5起利用AI工具造谣的典型案例。其中一起“合川区公安局依法查处石某利用AI工具编造虚假交通违法处理单网络谣言案”显示,2024年7月,合川区网民石某(男,45岁)在某短视频平台上发布一张交通违法处理单的图片,配文称,“开车时向女交警吹口哨,被罚款200块扣11分”。该视频引发大量网民关注和议论。

公安机关查明,石某为博取关注,利用AI软件炮制虚假交通违法处理单,扰乱公共秩序,造成不良社会影响。石某对违法行为供认不讳,合川区公安局已依法对石某处以行政处罚。

如何识别网络谣言

网络谣言已经成为亟须治理的一道网络新课题,在日常生活中,个人如何擦亮眼睛,识别并抵制网络谣言。

克制好奇之心。面对新奇夸张的信息,先别急着一探究竟。AI造谣就是选择、抓取大家关注的话题来制造网络谣言,利用网民好奇心来进行传播。

核实不明来源。切记不要盲目相信和传播未经证实的信息。在社交媒体或网络上看到可疑信息时,可以先进行核实或者等待官方消息发布后再做判断。

常用逻辑分析。要注意网络信息的逻辑性,如果发现一条信息在逻辑上存在明显的漏洞或矛盾,它很可能是经过篡改或杜撰的。

平台加强网络谣言的识别

造谣者以热点新闻和随机网络音视频为素材,通过AI软件,批量化生产网络谣言,投放到各大网络平台上,实现吸引眼球或流量变现的目的。而部分互联网平台奉行“流量至上”,放任假新闻、“标题党”、争议性话题传播,为AI谣言的大行其道提供了不良土壤,也催生了灰色产业链加速形成。内容平台需要在技术上、内容上和用户账号加强管理。

1、对内容加强真伪辨别。对可能涉及AI伪造的内容进行有效识别和及时处理,防止其对社会造成不良影响。例如,图像真实性检测工具能够通过分析像素级别的异常情况、图像生成中的“瑕疵”来判断图像是否经过AI生成。此外,通过分析用户的行为模式和身份信息,建立安全预警机制,对于异常登录、高频发送信息等可疑行为进行监控和限制。例如,分析鼠标移动模式、打字风格等用户行为模式并识别异常情况,标记偏离正常使用的可疑活动。并通过额外的身份和设备验证,以及大模型可以快速筛选海量数据,并识别出通常无法被人类检测到的细微不一致之处,发现攻击者的异常操作。

2、对内容增强多层验证。为了防止信息不实地传播,平台可以为某些敏感内容引入多层验证机制。通过整合第三方事实核查机构和AI工具,自动核实发布内容的真实性。若发现内容存在与事实不符的风险,平台可以为相关内容打上“待核实”或“疑似虚假信息”的标签。此外,平台可以通过用户举报系统和可信用户反馈帮助识别谣言内容,结合用户评价体系,将谣言信息自动标记为低可信度内容。

3、对账号建立信誉管理。平台可以通过分析用户行为模式和历史记录,识别恶意造谣者的行为特征。通过监控账号异常行为,如频繁发布敏感或不实信息、大量传播未经核实内容,平台可以及时识别并限制造谣行为。并建立用户信誉评分系统,基于用户发布内容的可信度、举报次数和行为记录来调整其内容传播范围。高风险用户可以受到内容发布限制或警告处理。

微信公众号

微信公众号 微信视频号

微信视频号